4096bit RSA Keys mit OpenPGP 2.1 Smartcards

Ich bereite die Einführung einer PGP PKI vor. Dazu habe ich mir ein paar Crypto Hardware Artikel beschafft und werde hier meine Erfahrungen verbloggen. Anfangen möchte ich mit den OpenPGP 2.1 Cards (von Zeitcontrol via Cryptoshop). Die Karten lassen sich direkt in dem connected Smart Card reader meines betagten Dell Latitude E6510 unter Windows 7 ansprechen. Dabei kommt der eingebaute Broadcom Reader zum Einsatz:

c:\Program Files\OpenSC Project\OpenSC\tools>opensc-tool -v -l

# Detected readers (pcsc)

Nr. Card Features Name

0 Yes Broadcom Corp Contacted SmartCard 0

3b:da:18:ff:81:b1:fe:75:1f:03:00:31:c5:73:c0:01:40:00:90:00:0c CryptoStick v1.2 (OpenPGP v2.0)

c:\Program Files (x86)\GNU\GnuPG>gpg2.exe --card-status

Application ID ...: D27600012401020100050000xxxx0000

Version ..........: 2.1

Manufacturer .....: ZeitControl

Serial number ....: 0000xxxx

Name of cardholder: Bernd Eckenfels

Language prefs ...: en

Sex ..............: männlich

Läßt sich also ohne Probleme sowohl mit OpenSC 0.15.0 Win64 sowie GnuPG 2.0.29 (GPG2Win 2.3.0) ansprechen. Ich konnte mit dieser Kombination auch 3072bit RSA Schlüssel erstellen und nutzen. Problematisch wird es allerdings wenn man 4096bit RSA Schlüssel nutzen möchte. Die Karten bieten diese Option an (deswegen habe ich sie auch ausgewählt). Leider kann der eingebaute Reader keine Extended-APDU, somit schlägt der Versuch fehl entsprechende Keys zu erzeugen (eigentlich sollte er die Keys erzeugen können aber es sieht danach aus dass die anschliessende Übertragung fehlschlägt:

tools> openpgp-tool -r 0 -v --verify CHV3 --pin 12345678 --gen-key 1 --key-len 3072 Connecting to card in reader Broadcom Corp Contacted SmartCard 0... Using card driver OpenPGP card. Fingerprint: 9DA81881C7139920120ABBF8C50BD95C 9A7C7684 tools> openpgp-tool -r 0 -v --verify CHV3 --pin 12345678 --gen-key 1 --key-len 4096 Connecting to card in reader Broadcom Corp Contacted SmartCard 0... Using card driver OpenPGP card. ... multiple minutes later... Failed to generate key. Error Transmit failed. c:\Program Files (x86)\GNU\GnuPG> gpg2.exe --card-status Application ID ...: D27600012401020100050000xxxx0000 Version ..........: 2.1 Manufacturer .....: ZeitControl Serial number ....: 0000xxxx Name of cardholder: Bernd Eckenfels Language prefs ...: en Sex ..............: männlich URL of public key : [nicht gesetzt] Login data .......: [nicht gesetzt] Signature PIN ....: nicht zwingend Key attributes ...: 4096R 4096R 4096R Max. PIN lengths .: 32 32 32 PIN retry counter : 3 0 3 Signature counter : 0 Signature key ....: [none] ...

Ach ja übrigens, noch ein paar Anmerkungen: Es ist wichtig gpg2.exe (nicht gpg.exe) zu verwenden, bei PGP4Win werden beide binaries in unterschiedlichen Versionen parallel installiert. Bei gpg2 muss man darauf achten dass es auf einige Hintergrundprozesse angewiesen ist (pinentry und scdaemon). Das kann schon mal zu Verwirrungen führen (z.b. Unter älteren Linux Varianten kann sich wohl ein Gnome daemon als pgp-agent ausgeben und dann smartcard befehle abweisen. Mit gpg-connect-agent -v und dem Befehl SCD GETINFO version lässt sich prüfen welcher Agent verwendt wird. In meinem Setup hängt sich auch die GPA artenverwaltng auch, habe noch nicht herausgefunden woran dies liegt.

Mit der Verwendung eines externen USB Readers der Extended APDU unterstützt (Gemalto IDBridge Ct710) lässt sich der 4096bit Key erstellen und nutzen:

c:\Program Files\OpenSC Project\OpenSC\tools>opensc-tool -v -l

# Detected readers (pcsc)

Nr. Card Features Name

0 Yes Broadcom Corp Contacted SmartCard 0

failed: Card not present

1 Yes PIN pad Gemalto IDBridge CT7xx 0

3b:da:18:ff:81:b1:fe:75:1f:03:00:31:c5:73:c0:01:40:00:90:00:0c CryptoStick v1.2 (OpenPGP v2.0)

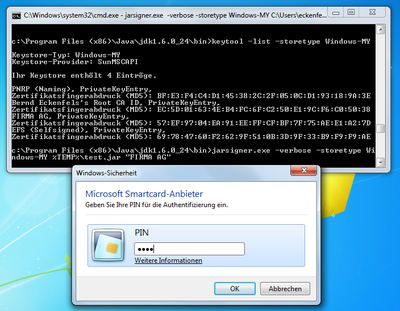

c:> echo debug-all > C:\users\eckenfel\AppData\Roaming\GnuPG\scdaemon.conf

c:> echo log file c:/temp/scdaemon.log >> C:\users\eckenfel\AppData\Roaming\GnuPG\scdaemon.conf

c:> echo reader-port "Gemalto IDBridge CT7xx 0" >> C:\users\eckenfel\AppData\Roaming\GnuPG\scdaemon.conf

c:\Program Files (x86)\GNU\GnuPG> gpg2 --card-edit -v

Application ID ...: D27600012401020100050000xxxx0000

Version ..........: 2.1

...

gpg/card> admin

gpg/card> generate

Make off-card backup of encryption key? (Y/n) n

gpg: NOTE: keys are already stored on the card!

Replace existing keys? (y/N) y

What keysize do you want for the Signature key? (3072) 4096

The card will now be re-configured to generate a key of 4096 bits

What keysize do you want for the Encryption key? (3072) 4096

The card will now be re-configured to generate a key of 4096 bits

What keysize do you want for the Authentication key? (3072) 4096

The card will now be re-configured to generate a key of 4096 bits

...

Change (N)ame, (C)omment, (E)mail or (O)kay/(Q)uit? o

gpg: writing self signature

gpg: RSA/SHA256 signature from: "CE551545 [?]"

gpg: writing key binding signature

gpg: RSA/SHA256 signature from: "CE551545 [?]"

gpg: writing key binding signature

gpg: RSA/SHA256 signature from: "CE551545 [?]"

gpg: writing key binding signature

gpg: RSA/SHA256 signature from: "CE551545 [?]"

gpg: writing key binding signature

gpg: RSA/SHA256 signature from: "CE551545 [?]"

gpg: writing public key to `C:/Users/eckenfel/AppData/Roaming/gnupg/pubring.gpg'

gpg: writing secret key stub to `C:/Users/eckenfel/AppData/Roaming/gnupg/secring.gpg'

gpg: using PGP trust model

gpg: key CE551545 marked as ultimately trusted

public and secret key created and signed.

pub 4096R/CE551545 2016-06-05 [expires: 2016-06-06]

Key fingerprint = 1C93 E95E 0486 C55C 0762 3629 20CC CA05 CE55 1545

uid [ultimate] Bernd Eckenfels (test) <test@test>

sub 4096R/F738D4AE 2016-06-05 [expires: 2016-06-06]

sub 4096R/309D4991 2016-06-05 [expires: 2016-06-06]

Das Erstellen von 3 Schlüsseln (inkl. Signaturen, ohne Encryption Key backup - d.h. auch auf der Karte erstellt) mit 4096 bit dauert (stark schwankend) 30 Minuten, die selbe Prozedur mit 3072 bit Schlüssel erfolgt in 8 Minuten.

Bei der Erstellung der Schlüssel gibt pgp2 wenige Zwischenschritte aus, man kann das ganze aber im scdaemon logfile nachvollziehen. Wie oben zu sehen war es auch notwendig den Klartext Namen des externen Card Readers zu konfigurieren, scdaemon hat reader-port 1 oder reader-port 32769 (trotz Neustart) schlichtweg ignoriert. Auch wenn der richtige Reader verwendet wird scheint die Debug Ausgabe nur den Slot des Readers aber nicht den gewählten Reader auszugeben:

scdaemon[14808] Handhabungsroutine f³r fd -1 gestartet scdaemon[14808] detected reader `Broadcom Corp Contacted SmartCard 0' scdaemon[14808] detected reader `Gemalto IDBridge CT7xx 0' scdaemon[14808] detected reader `' scdaemon[14808] reader slot 0: not connected

Bei der Key-Erstellung hat gnupg2 das externe Keypad des Gemalto readers für die PIN Eingabe (noch) nicht benutzt.